Hay récords que permanecen décadas imbatidos y otros que tan solo duran segundos, como el de la atleta de heptatlón Adrianna Sulek, que solo disfrutó de su marca mundial 6,43 segundos. En la informal competición entre la computación clásica y cuántica además sucede. El pasado 14 de junio, una investigación publicada en Nature aseguraba ocurrir conseguido con 127 cúbits, capacidad ya presente en los ordenadores cuánticos comerciales, resultados imposibles en la computación clásica. Solo dos semanas posteriormente, sendos trabajos de Caltech y de la Universidad de Nueva York reivindicaron ocurrir acabado resoluciones más precisas con computación clásica. “Esta pugna entre lo clásico y lo cuántico es muy enriquecedora”, comenta David Pérez García, investigador del Instituto de Ciencias Matemáticas (Icmat) y catedrático de la Universidad Complutense de Madrid.

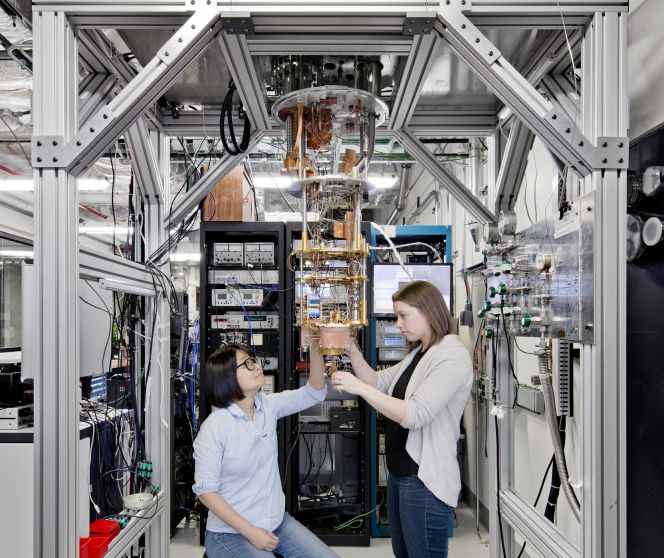

Youngseok Kim, Andrew Eddins y Abhinav Kadala, investigadores de IBM, conexo a otros autores, afirmaron en Nature ocurrir evidenciado que un procesador cuántico y un procesamiento posterior al disección pueden crear, manipular y valorar de guisa confiable estados cuánticos tan complejos que sus propiedades no podrían estimarse de forma precisa mediante aproximaciones convencionales.

“Ninguna computadora clásica tiene suficiente memoria para codificar las posibilidades calculadas por los 127 cúbits”, afirmaron los autores. Göran Wendin y Jonas Bylander, investigadores de la Universidad de Tecnología de Chalmers (Suecia), lo respaldaron: “La superioridad cuántica fundamental aquí es la escalera en oficio de la prontitud: los 127 cúbits codifican un problema para el cual ninguna computadora clásica tiene suficiente memoria”.

“Bienes modestos”

Sin confiscación, este récord solo supuso un estímulo para intentar batirlo. Investigadores del Flatiron Institute Center de física cuántica computacional aceptaron el desafío y, en solo 12 días, publicaron una investigación con una “simulación clásica, precisa y eficaz en memoria y tiempo”, del sistema difundido en Nature. “Al adoptar un enfoque de red tensorial, podemos realizar una simulación clásica que es significativamente más precisa que los resultados obtenidos por el dispositivo cuántico”, aseguran los autores, quienes destacan que se ha hecho con “bienes computacionales modestos”.

Tan solo dos días posteriormente, investigadores de Caltech (Instituto de Tecnología de California) mostraban otro trabajo en el que “un cálculo clásico basado en la dinámica dispersa de Pauli puede afectar eficientemente los circuitos cuánticos estudiados en el examen flamante con los 127 cúbits del procesador Eagle de IBM”.

Los investigadores hacen relato al artículo publicado solo dos días ayer para afirmar: “El hecho de que los dos enfoques clásicos tengan éxito ilustra el rico panorama de algoritmos clásicos aproximados que aún no se han explorado. Creemos que el método que describimos aquí es prometedor no solo para las simulaciones de circuitos cuánticos, sino además para problemas de simulación más generales en dinámica cuántica”.

Todas son buenas

El profesor e investigador David Pérez García, perito en redes de tensores (la táctica desarrollada en el primero de los trabajos alternativos al de superioridad cuántica), considera “sorprendentes” las tres investigaciones: “Son espectaculares. Que diferentes técnicas reproduzcan los resultados del examen da hasta más valencia. Los resultados son buenos. No son ruido”.

Lo que sí contradicen los trabajos alternativos al publicado en Nature es la conclusión de que es impracticable alcanzar los mismos resultados con otras formas de computación. “Demuestran que el examen [de IBM] no está en el punto de afirmar que no es simulable con ningún método clásico”, zanja Pérez García.

“Pero no creo que la superioridad cuántica fuera era el objetivo principal, sino que se pueden obtener resultados buenos en sistemas grandes, complejos, sin tener que acontecer a corrección de errores, que es el sueño ideal de la computación cuántica. Hay un término medio que es la mitigación de errores y que puede aportar resultados muy interesantes”, añade el investigador gachupin.

Las técnicas utilizadas se desarrollaron para afectar el comportamiento de sistemas cuánticos con ordenadores clásicos. “La propia simulación muestra que estas ideas que están usando son interesantes y se pueden usar para otro tipo de problemas. El campo es muy dinámico. Las dificultades estar ahí y, aunque todavía no se pueden propalar las campanas al revoloteo para sostener que esta tecnología ya es una efectividad, sí que se observan avances muy prometedores”, resalta Pérez García.

Puedes seguir a EL PAÍS Tecnología en Facebook y Twitter o apuntarte aquí para aceptar nuestra newsletter semanal.

Suscríbete para seguir leyendo

Lee sin límites

Creditos a Raúl Citrón

Fuente