コミネ(KOMINE) バイク用 JK-5961 プロテクトウインタージャケット Solid Black XL

(税込) 送料込み

商品の説明

商品情報

コミネ(KOMINE) バイク用 JK-5961 プロテクトウインタージャケット Solid Black XL

14940円コミネ(KOMINE) バイク用 JK-5961 プロテクトウインタージャケット Solid Black XL車、バイク、自転車バイクコミネ公式】JK-5961 プロテクトウインタージャケット | CATEGORY

商品コード:16058705124

型番:07-5961

サイズ:XL

カラー:Solid Black

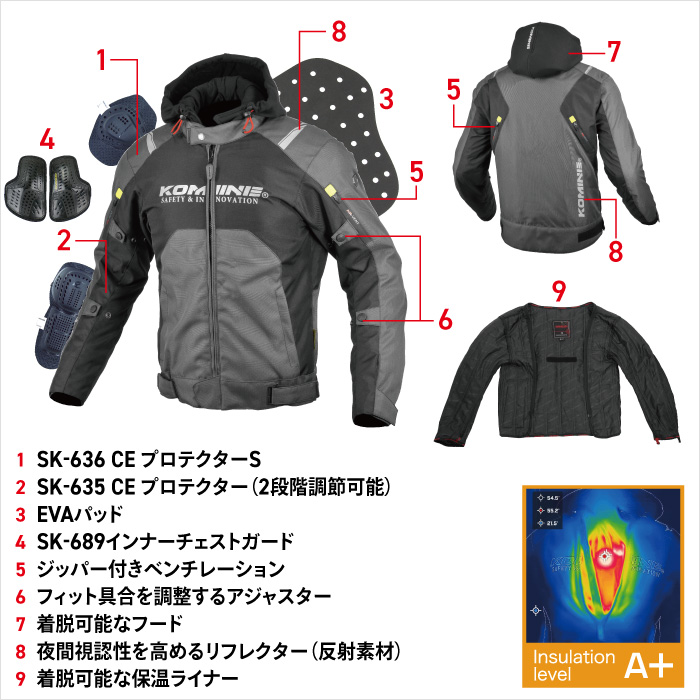

ベーシックな仕様のウインタージャッケット。スェット生地のフードを着脱することで、カジュアルにも、ライディングウェア然とした着こなしにも対応。別売り電熱ライナーベスト(EK-101)をオプション装着可能。・フード付きテキスタイルジャケット ・着脱可能な保温ライナー付属 ・乗車姿勢を取りやすい立体パターン ・CE規格ハードプロテクター標準装備(肩 / SK-636, 肘 / SK-635) ・EVA脊椎パッド ・ハードタイプ胸部プロテクター標準装備(SK-689) ・夜間被視認性を高めるリフレクター ・ウエストアジャスター ・アジャスター(上腕・前腕) ・着脱可能スウェットフード ・コピー防止4Dラベル

梱包サイズ:Amazon | コミネ(KOMINE) バイク用 JK-5961 プロテクトウインター

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

KOMINE コミネ JK-5961 プロテクトウインタージャケット Protect

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ プロテクトウインタージャケット JK-5961 (バイク用ウェア

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ公式】JK-5961 プロテクトウインタージャケット | CATEGORY

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ JK-5961 プロテクトウインタージャケット - オートバイアクセサリー

コミネ ジャケット JK-5961 プロテクトウインタージャケット KOMINE 07-5961 バイク ジャケット 防寒 CE規格パッド付 2023年新色追加

KOMINE JK-5961 プロテクトウインタージャケット Basalt Grey 07-5961

正規品/KOMINE ジャケット 2021-2022秋冬モデル JK-5961 プロテクトウインタージャケット(ソリッドブラック) サイズ:XL コ… : 1127426-2368348 : パークアップバイクYahoo!店 - 通販 - Yahoo!ショッピング

Amazon | コミネ(KOMINE) バイク用 JK-5961 プロテクトウインター

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

楽天市場】バイク用ウィンタージャケットカジュアルKOMINE(コミネ

Amazon | コミネ(KOMINE) バイク用 JK-5961 プロテクトウインター

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ プロテクトウインタージャケット JK-5961 (バイク用ウェア

コミネ(KOMINE) JK-5961 プロテクトウインタージャケット Olive XL

コミネ JK-5961 プロテクトウインタージャケット - オートバイアクセサリー

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

JK-5961 プロテクトウインタージャケット Solid Black

楽天市場】バイク用ウィンタージャケットカジュアルKOMINE(コミネ

Amazon | コミネ(KOMINE) バイク用 JK-5961 プロテクトウインター

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ公式】JK-5961 プロテクトウインタージャケット | CATEGORY

コミネ ジャケット JK-5961 プロテクトウインタージャケット KOMINE 07-5961 バイク ジャケット 防寒 CE規格パッド付 2023年新色追加

Amazon | コミネ(KOMINE) バイク用 JK-5961 プロテクトウインター

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

コミネ ジャケット JK-5961 プロテクトウインタージャケット KOMINE 07

楽天市場】コミネ ジャケット JK-5961 プロテクトウインタージャケット

KOMINE JK-5961 プロテクトウインタージャケット Solid Black 07-5961

コミネ(KOMINE) バイク用プロテクター ジャケット JK-140 - バイク

KOMINE(コミネ) / JK-5961 バイク/プロテクトウインタージャケット

Webike | KOMINE コミネ JK-5961 プロテクトウインタージャケット(07

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

楽天市場】コミネ ジャケット JK-5961 プロテクトウインタージャケット

コミネ JK-5961 プロテクトウインタージャケット - バイクウエア/装備

☆JK-603 プロテクトウィンタージャケット

秋冬 ウインターKOMINE コミネ JK-5961 プロテクトウインタージャケット JK-5961 Protect Winter Jacket バイクジャケット 防寒 防水

商品の情報

メルカリ安心への取り組み

お金は事務局に支払われ、評価後に振り込まれます

出品者

スピード発送

この出品者は平均24時間以内に発送しています