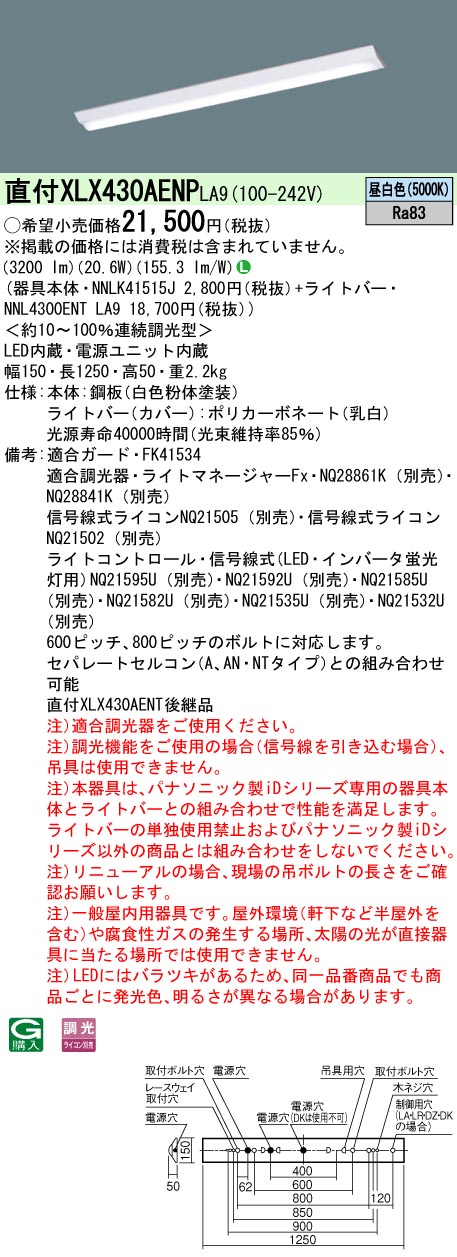

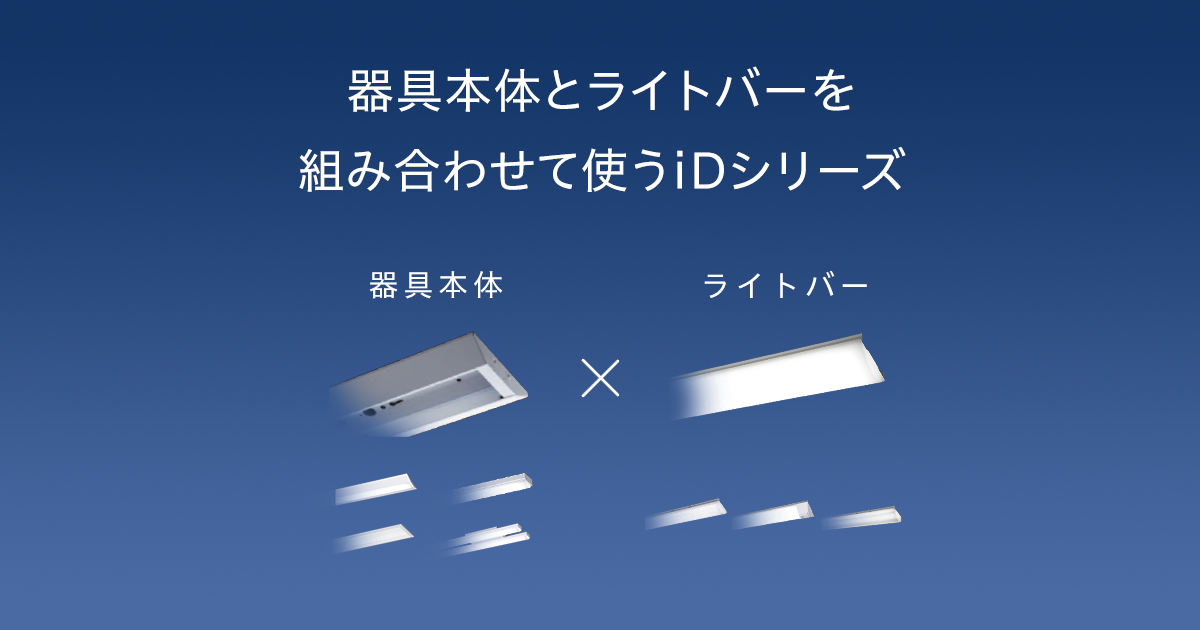

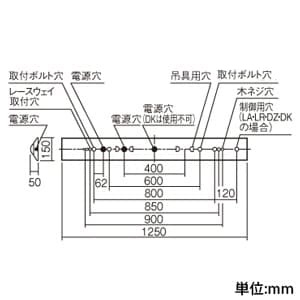

パナソニック XLX430AENPLA9 一体型LEDベースライトIDシリーズ40形 直付型 Dスタイル W150 調光 3200lm 昼白色

(税込) 送料込み

商品の説明

商品情報

XLX430AENPLA9

6885円パナソニック XLX430AENPLA9 一体型LEDベースライトIDシリーズ40形 直付型 Dスタイル W150 調光 3200lm 昼白色家具、インテリア照明、電球パナソニック iDシリーズ/40形 直付型 Dスタイル 逆富士型 W150XLX430AENPLA9 iDシリーズ 40形 直付型 Dスタイル W150 一般タイプ 調

パナソニック XLX430AENPLA9 一体型LEDベースライトIDシリーズ40形 直

超歓迎された】 ◎直付XLX430AENP LA9【当店おすすめ!iDシリーズ】 一

パナソニック 一体型LEDベースライト 《iDシリーズ》 40形 直付型 Dスタイル W230 一般タイプ 3200lmタイプ Hf32形高出力型器具×1灯相当 昼白色 XLX430DENPLE9 | 電材堂

パナソニック XLX430AENPLE9 一体型LEDベースライトIDシリーズ40形 直

パナソニック 一体型LEDベースライト iDシリーズ 40形 直付型 Dスタイル W150 一般タイプ 5200lmタイプ 非調光タイプ 昼白色 XLX450AENPLE9 | 電材堂

◎直付XLX430AENP LA9【当店おすすめ!iDシリーズ】 一体型LEDベースライト 40形 直付型Dスタイル/富士型 W150 一般・3200lmタイプHf蛍光灯32形高出力型1灯器具相当 昼白色 調光Panasonic 店舗・施設用照明 天井照明 基礎照明

Amazon.co.jp: パナソニック(Panasonic) 一体型LEDベースライト iD

楽天市場】パナソニック 一体型LEDベースライト《iDシリーズ》40形 直

パナソニック LEDベースライト iDシリーズ Dスタイル/富士型 Hf32高

一体型LEDベースライト「iDシリーズ」映光色タイプ | 施設用照明器具

パナソニック iDシリーズ/40形 直付型 Dスタイル 逆富士型 W150

(法人様宛限定)(送料無料)パナソニック XLX430AENPLE9 天井直付型 40形 一体型LEDベースライト 一般タイプ 3200 lmタイプ 昼白色 (XLX430AENTLE9の後継品) : xlx430aentle9 : 住設と電材の洛電マート plus - 通販 -

楽天市場】パナソニック(Panasonic) 一体型LEDベースライト 《iD

[法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直付型 40形 一体型LEDベースライト 昼白色 非調光 [ XLX450AENPLE9 ] : 101k02721 : 照明専門店ライトエキスパート - 通販 - Yahoo!ショッピング

パナソニック iDシリーズ/40形 直付型 Dスタイル 逆富士型 W150

一体型LEDベースライト「iDシリーズ」映光色タイプ | 施設用照明器具

パナソニック直付XLX430DENZ LE9一体型LEDベースライト iDシリーズ 40

Amazon | パナソニック(Panasonic) 一体型LEDベースライト iDシリーズ

一体型LEDベースライト「iDシリーズ」映光色タイプ | 施設用照明器具

楽天市場】パナソニック 一体型LEDベースライト iDシリーズ 40形 直付

パナソニック直付XLX450AEN LE9一体型LEDベースライト iDシリーズ 40形

Amazon | パナソニック(Panasonic) 一体型LEDベースライト iDシリーズ

法人限定][即納在庫有り] XLX430NEWP LE9 パナソニック iDシリーズ 直

XLX430AENPLA9 | 施設照明 | ◎直付XLX430AENP LA9【当店おすすめ!iD

パナソニック iDシリーズ/40形 直付型 Dスタイル 逆富士型 W150

お取り寄せ 納期回答致します XLX430NENP LE9 天井直付型 40形 一体型

一体型LEDベースライト「iDシリーズ」映光色タイプ | 施設用照明器具

【楽天市場】パナソニック 一体型LEDベースライト 《iDシリーズ

Amazon.co.jp: パナソニック(Panasonic) 一体型LEDベースライト iD

法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直

パナソニック iDシリーズ/40形 直付型 Dスタイル 逆富士型 W150

Amazon | パナソニック(Panasonic) 一体型LEDベースライト iDシリーズ

楽天市場】xlx430aenp le9の通販

[法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直付型 40形 一体型LEDベースライト 昼白色 非調光 [ XLX450AENPLE9 ]

Amazon.co.jp: パナソニック 一体型LEDベースライト 直付型 Dスタイル

パナソニック LEDベースライト iDシリーズ Dスタイル/富士型 Hf32高

楽天市場】パナソニック 一体型LEDベースライト iDシリーズ 本体

XLX430NENZ | 照明器具検索 | 照明器具 | Panasonic

[法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直付型 40形 一体型LEDベースライト 昼白色 非調光 [ XLX450AENPLE9 ]

商品の情報

メルカリ安心への取り組み

お金は事務局に支払われ、評価後に振り込まれます

出品者

スピード発送

この出品者は平均24時間以内に発送しています

![[法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直付型 40形 一体型LEDベースライト 昼白色 非調光 [ XLX450AENPLE9 ]](https://shopping.c.yimg.jp/lib/light-expert/item-img_hason.jpg)

![[法人限定][即納在庫有り] XLX450AENP LE9 パナソニック iDシリーズ 直付型 40形 一体型LEDベースライト 昼白色 非調光 [ XLX450AENPLE9 ]](https://shopping.c.yimg.jp/lib/light-expert/item-img_zaiko.jpg)