ベンツ 輸入車 パーツEWAY Universal Microwave Radar Blind Spots Detection Auto Safety Monitoring_並行輸入品

(税込) 送料込み

商品の説明

商品情報

本商品は海外倉庫により発送されます。その為お届けまで5-12営業日程度お時間をいただいております。■税関手続き、関税支払い等すべて当方で対応させていただいております。ご安心くださいませ。

36787円ベンツ 輸入車 パーツEWAY Universal Microwave Radar Blind Spots Detection Auto Safety Monitoring_並行輸入品車、バイク、自転車自動車Driintel 77GHz RCTA AOA Millimeter Wave Radar blind spot detectionEWAY Universal Microwave Radar Blind Spots Detection Auto Safety

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

EWAY Car Microwave Blind Spot Radar Detectors - Amazon.com

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Universal Car Radar Blind Spot Sensor System – Ewaysafety

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Safe Driving Spot Monitor Assist Car Blind Spot Deteltion System

Universal Car Radar Blind Spot Sensor System – Ewaysafety

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Universal Car Radar Blind Spot Sensor System – Ewaysafety

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Autodragons car aftermarket universal microwave sensor| Alibaba.com

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Bsm-01 Universal Microwave Blind Spot Detection System with High

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Universal Car Blind Spot Detection System manufacturer,Universal

Autodragons car aftermarket universal microwave sensor| Alibaba.com

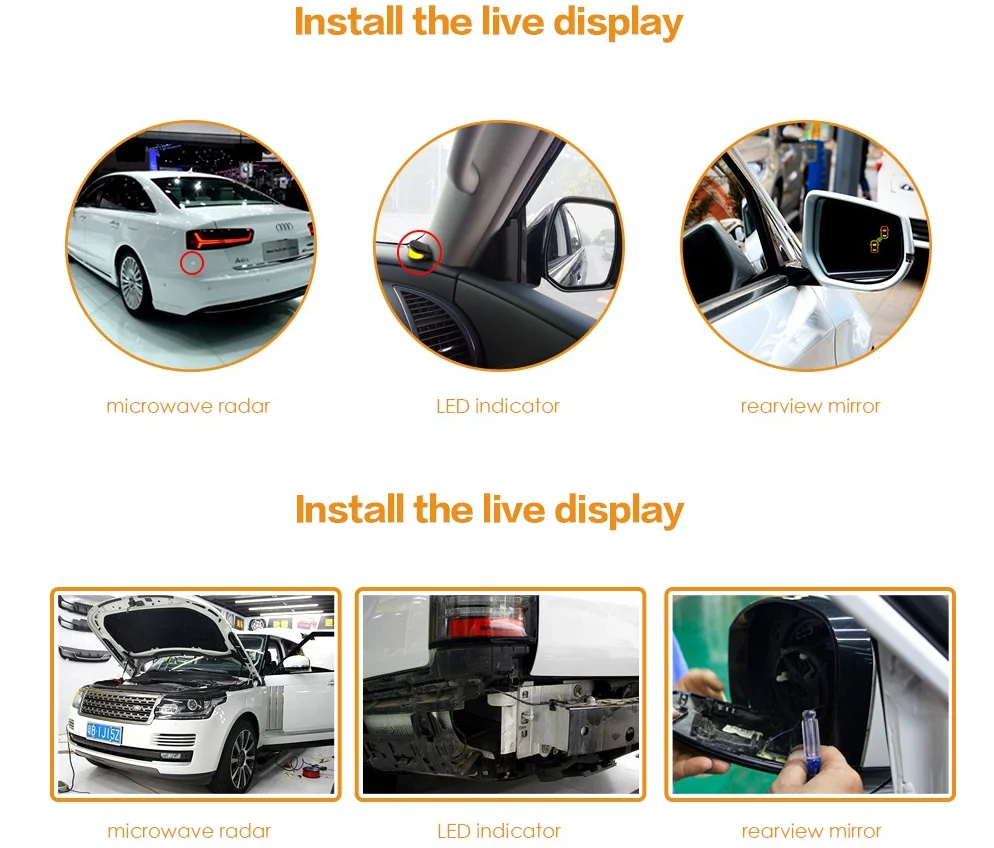

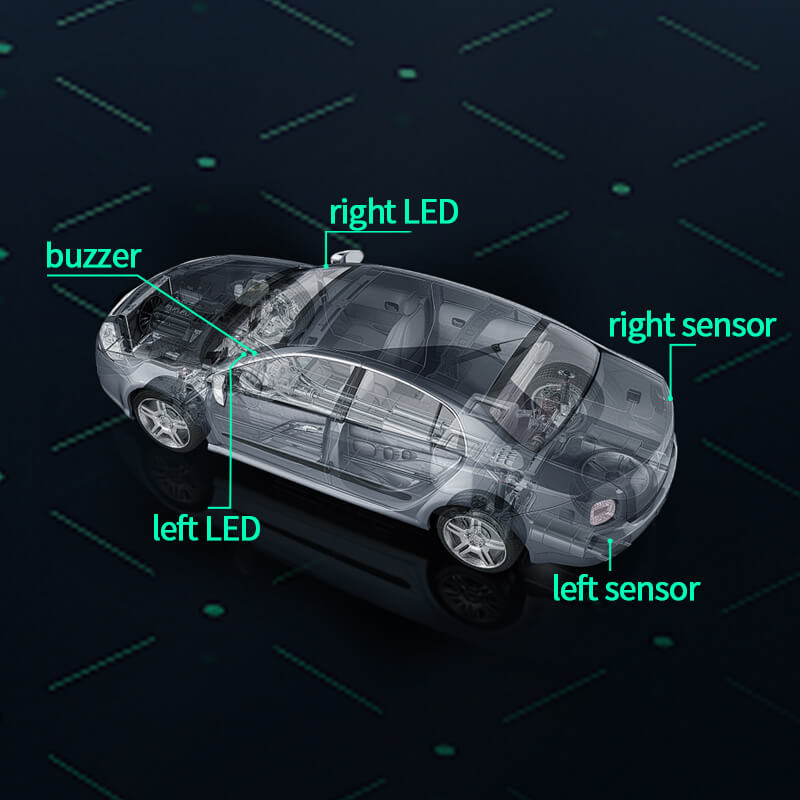

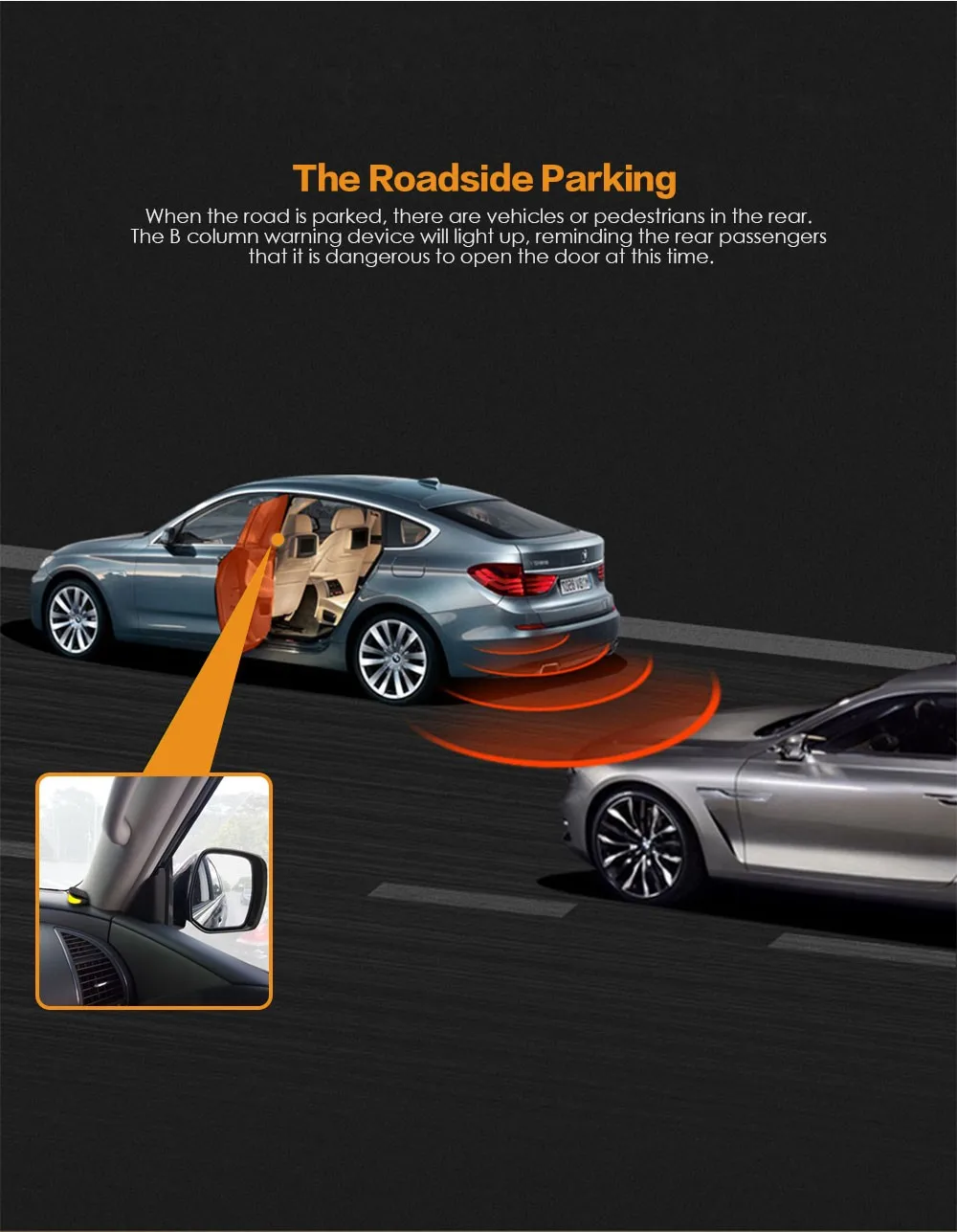

Car Blind Spot Monitoring BSM Universal Radar- Detection System Microwave Sensor

Car Blind Spot Monitoring BSM Universal Radar- Detection System Microwave Sensor

Driintel 77GHz RCTA AOA Millimeter Wave Radar blind spot detection

Car Blind Spot Monitoring BSM Universal Radar- Detection System Microwave Sensor

Car Blind Spot Mirror Radar Detection System for Mercedes-Benz GLC 2015-2021 BSD Microwave Monitoring Assistant Driving Security

Car Blind Spot Monitoring BSM Universal Radar- Detection System Microwave Sensor

77GHz Universal Car Radar Blind Spot Sensor System – Ewaysafety

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Car Blind Spot Monitoring BSM Universal Radar- Detection System Microwave Sensor

Autodragons car aftermarket universal microwave sensor| Alibaba.com

Car Blind Spot Mirror Radar Detection System For Mercedes-benz Glc

Microwave Blind Spot Detection Radar BS300 – Autoease

Microwave Radar Universal Car Blind Spot Detection Rear Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Autodragons car aftermarket universal microwave sensor| Alibaba.com

Amazon.com: EWAY Car Microwave Blind Spot Radar Detectors Sensor

Car Blind Spot Monitoring BSM Universal Radar- Detection System

商品の情報

メルカリ安心への取り組み

お金は事務局に支払われ、評価後に振り込まれます

出品者

スピード発送

この出品者は平均24時間以内に発送しています